Review sản phẩm

BERT: Bí Mật Đằng Sau Sự Thông Minh Của Ngôn Ngữ

## BERT: Bí Mật Đằng Sau Sự Thông Minh Của Ngôn Ngữ

BERT (Bidirectional Encoder Representations from Transformers) là một mô hình ngôn ngữ mạnh mẽ do Google phát triển, đánh dấu một bước tiến vượt bậc trong lĩnh vực xử lý ngôn ngữ tự nhiên (NLP). Bài viết này sẽ giúp bạn hiểu BERT là gì và cơ chế hoạt động thần kỳ của nó.

BERT hoạt động như thế nào?

Khác với các mô hình ngôn ngữ trước đây chỉ xử lý văn bản theo một chiều (từ trái sang phải hoặc ngược lại), BERT sử dụng mã hóa song hướng (bidirectional). Điều này có nghĩa là mô hình xem xét toàn bộ ngữ cảnh của một từ, cả trước và sau nó, để hiểu nghĩa chính xác. Việc này cho phép BERT nắm bắt được sự tinh tế và phức tạp của ngôn ngữ con người một cách hiệu quả hơn.

Cốt lõi của BERT là kiến trúc Transformer: Đây là một loại mạng nơ-ron nhân tạo dựa trên cơ chế “attention”, cho phép mô hình tập trung vào các phần quan trọng nhất của câu để hiểu ý nghĩa. Transformer giúp BERT xử lý văn bản dài một cách hiệu quả và song song, khác với các mô hình tuần tự truyền thống, giúp tăng tốc độ xử lý đáng kể.

Ứng dụng của BERT:

Khả năng hiểu ngữ cảnh sâu sắc của BERT đã mở ra vô vàn ứng dụng trong nhiều lĩnh vực:

* Phân loại văn bản: BERT có thể phân loại văn bản chính xác hơn, chẳng hạn như phân loại email là spam hay không spam, hoặc phân loại cảm xúc trong bài viết.

* Trích xuất thông tin: BERT giúp trích xuất thông tin quan trọng từ văn bản một cách chính xác và hiệu quả, ví dụ như trích xuất tên, địa điểm, ngày tháng từ một bài báo.

* Tóm tắt văn bản: BERT có thể tự động tạo ra các bản tóm tắt ngắn gọn và chính xác của văn bản dài.

* Dịch máy: BERT được sử dụng để cải thiện chất lượng dịch máy, giúp cho bản dịch tự nhiên và chính xác hơn.

* Tạo câu hỏi – câu trả lời: BERT có thể trả lời câu hỏi dựa trên một đoạn văn bản cho trước.

Kết luận:

BERT là một bước tiến quan trọng trong lĩnh vực NLP, mang lại khả năng hiểu và xử lý ngôn ngữ tự nhiên một cách chính xác và hiệu quả hơn bao giờ hết. Sự phát triển của BERT đã mở ra nhiều cơ hội mới cho các ứng dụng thực tế, từ tìm kiếm thông tin đến dịch máy và nhiều hơn nữa.

—

(Phần này không liên quan đến nội dung về BERT, cần tách riêng)

Mua ngay sản phẩm tại Queen Mobile!

Queen Mobile là địa chỉ tin cậy cung cấp các sản phẩm điện thoại iPhone, máy tính bảng iPad và nhiều phụ kiện chính hãng. Hãy đến với Queen Mobile để trải nghiệm dịch vụ tốt nhất và sở hữu những sản phẩm công nghệ hiện đại.

#BERT #XửLýNgônNgữTựNhiên #NLP #Google #MôHìnhNgônNgữ #TríTuệNhânTạo #AI #QueenMobile #iPhone #iPad

Giới thiệu What is the BERT language model and how does it work?

: What is the BERT language model and how does it work?

Hãy viết lại bài viết dài kèm hashtag về việc đánh giá sản phẩm và mua ngay tại Queen Mobile bằng tiếng VIệt: What is the BERT language model and how does it work?

Mua ngay sản phẩm tại Việt Nam:

QUEEN MOBILE chuyên cung cấp điện thoại Iphone, máy tính bảng Ipad, đồng hồ Smartwatch và các phụ kiện APPLE và các giải pháp điện tử và nhà thông minh. Queen Mobile rất hân hạnh được phục vụ quý khách….

_____________________________________________________

Mua #Điện_thoại #iphone #ipad #macbook #samsung #xiaomi #poco #oppo #snapdragon giá tốt, hãy ghé [𝑸𝑼𝑬𝑬𝑵 𝑴𝑶𝑩𝑰𝑳𝑬]

✿ 149 Hòa Bình, phường Hiệp Tân, quận Tân Phú, TP HCM

✿ 402B, Hai Bà Trưng, P Tân Định, Q 1, HCM

✿ 287 đường 3/2 P 10, Q 10, HCM

Hotline (miễn phí) 19003190

Thu cũ đổi mới

Rẻ hơn hoàn tiền

Góp 0%

Thời gian làm việc: 9h – 21h.

KẾT LUẬN

Hãy viết đoạn tóm tắt về nội dung bằng tiếng việt kích thích người mua: What is the BERT language model and how does it work?

BERT is an AI language model Google developed before Bard. It serves a different purpose and was operational years before OpenAI launched ChatGPT. Google is a leader in artificial intelligence, building AI into Android, Nest smart speakers, and more. Every time you access Google Assistant, that’s an AI answering.

What does BERT stand for?

BERT stands for Bidirectional Encoder Representations from Transformers. The full name isn’t very helpful unless you’re familiar with AI terminology. The easiest way to explain it is to break it down one term at a time.

- Bidirectional means the process works in two directions. When scanning a sentence, BERT looks for word associations to the left and the right. While we read left to right, we understand that related words can exist on either side. BERT knows that also.

- An encoder is a way of encapsulating information in a compact and useful way. BERT encodes data in a way that makes sense for its unique purposes.

- BERT uses an internal representation of language to simplify and speed up processing. Google Translate uses a similar process when translating between more than a hundred natural languages. The AI creates an internal language that facilitates this process.

- Transformers are a critically important AI concept. It’s a neural network consisting of two layers. Attention layers identify what to focus on by assigning weights to the most relevant piece of data. Feed-forward layers pass data ahead to learn complex patterns.

How is BERT different from Bard?

Google has used AI for many years, but BERT was one of the first language models released as open source, following OpenAI’s GPT-1. OpenAI’s Generative Pre-trained Transformer 1 used Google’s 2017 AI transformer concept. BERT doesn’t accept user input. It works behind the scenes to improve Google Search results.

Bard is Google’s latest AI, a chatbot that responds to questions and follows user commands. It’s a large language model similar to OpenAI’s GPT-4 or Microsoft’s Bing. Google launched Bard in February 2023. Unlike BERT, Bard is not an open source project. If you want to learn more about Google Bard and how it works, we have an article that explains what Bard can do.

How was BERT trained?

Google trained BERT on Wikipedia articles and Toronto BookCorpus, a collection of free online books. This type of data is known as unlabeled text, and BERT uses unsupervised learning. The AI sees the text in a raw form without human input or hints about the meaning or structure. Google fine-tuned the model for natural language processing (NLP), such as answering questions, understanding sentiment, and recognizing people and organizations.

When Google released BERT in 2018, it surpassed previous models by a large margin. Google gave BERT a significant update in October 2019 and began using it to improve search results.

How does Google use BERT?

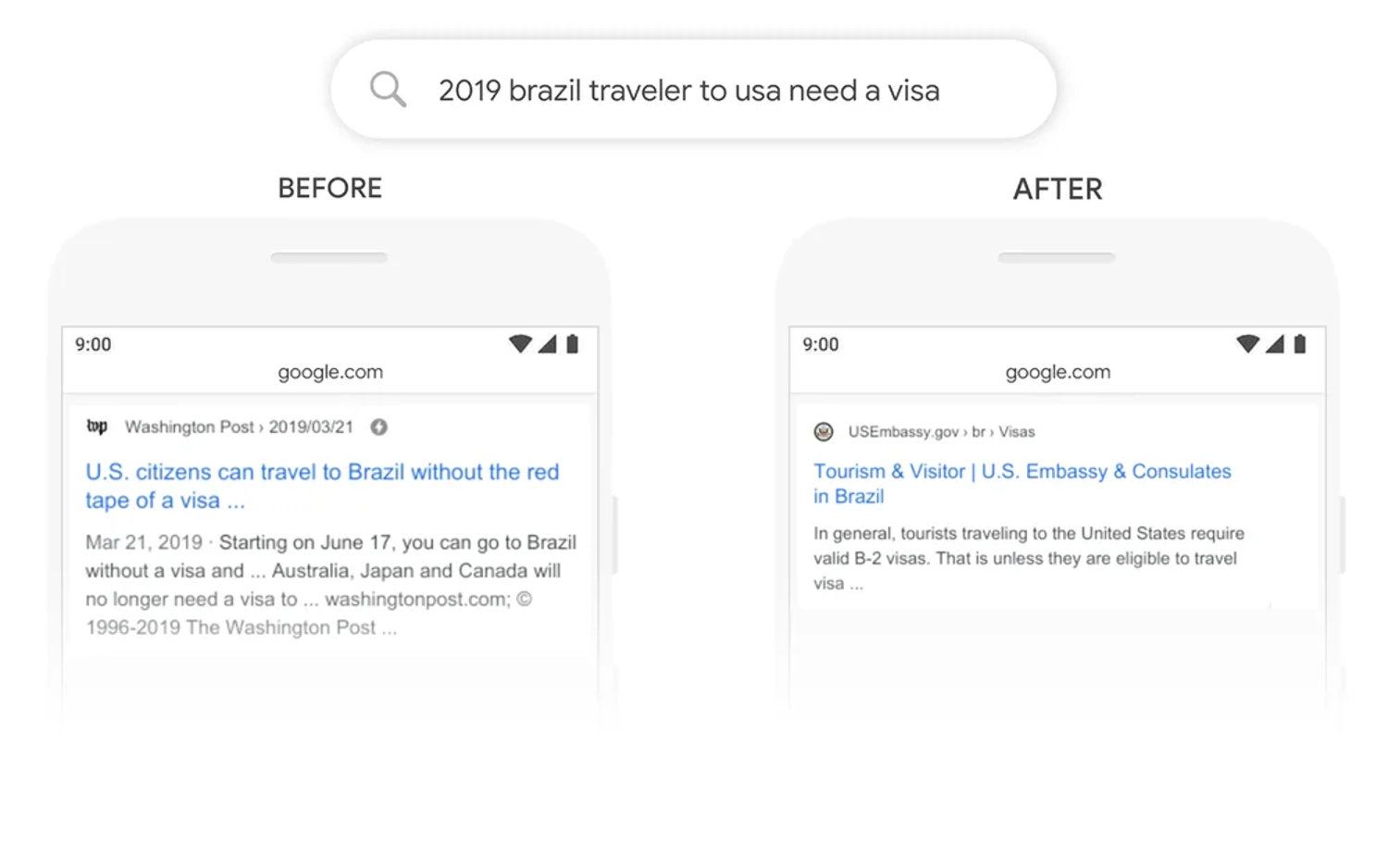

Google now uses BERT running on Google Cloud TPUs to improve Google Search’s ability to understand your query and deliver the most relevant search results. Google Search can understand long, conversational questions that contain prepositions like “for” and “to,” thanks to BERT’s bidirectional understanding that considers the influence of surrounding words.

Google Search collects and indexes data from billions of diverse websites. Understanding language, context, and the subject is critical to finding relevant listings and surfacing the most important details. Google gave an excellent example in its blog post about integrating BERT into search.

Source: Google

In a search for “2019 brazil traveler to usa need a visa,” BERT recognizes the preposition “to” suggests the results should show listings about a Brazilian getting a visa to visit the U.S. Previous search results incorrectly show information for a U.S. citizen getting a visa to go to Brazil. Now, Google Search understands the whole query rather than simply identifying keyword matches.

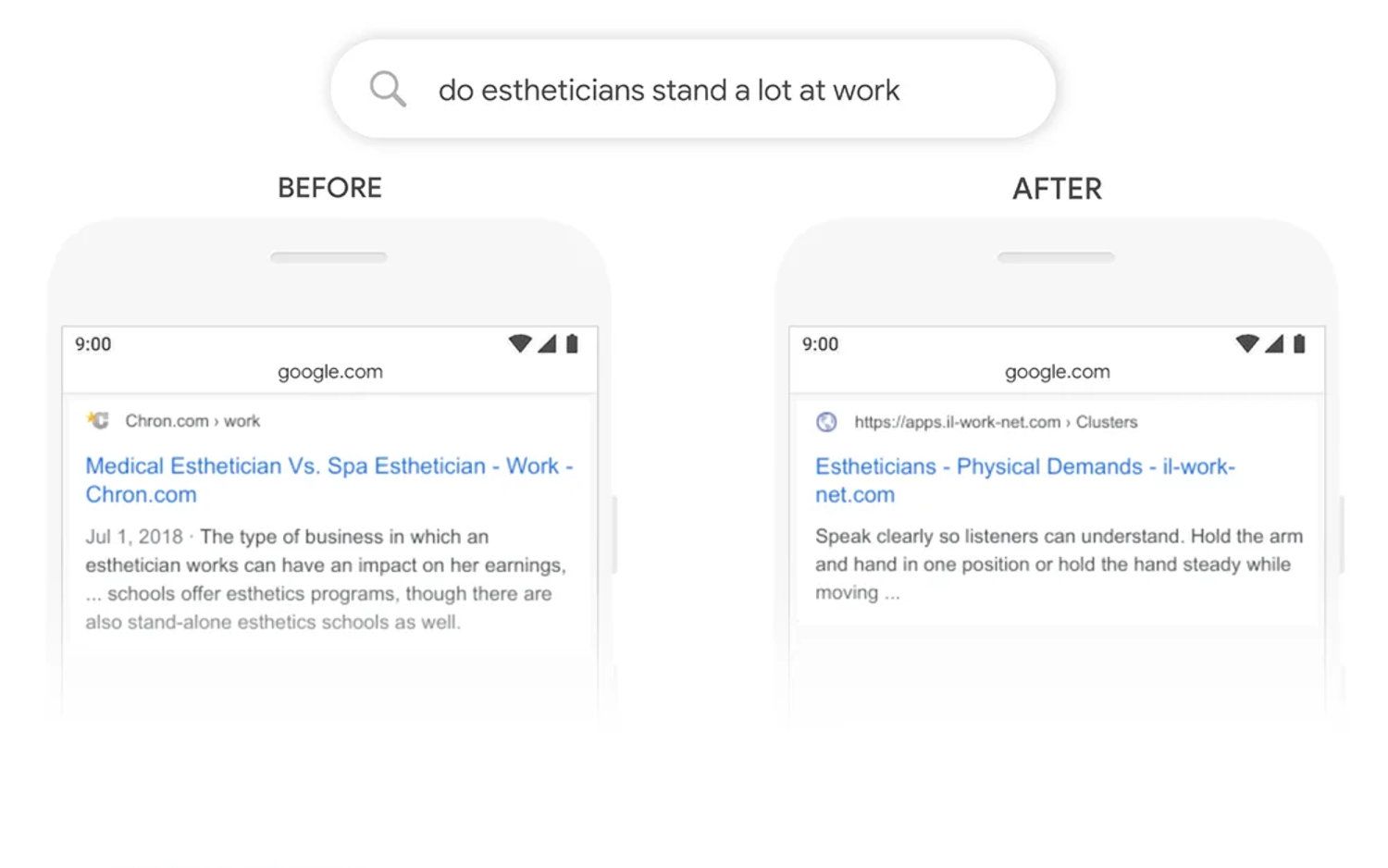

Source: Google

Another example, “do estheticians stand a lot at work,” shows awareness of the context of keywords. Previously, Google Search matched the term “stand-alone,” but BERT correctly recognizes the question is about estheticians standing on their feet while at work. Google ends that blog post by acknowledging that “Search is not a solved problem.”

Which AI is next for Google Search?

Google’s Shopping Graph, introduced in 2020, uses AI to improve product searches. In 2021, Google introduced the Multitask Unified Model (MUM), describing it as 1,000 times more powerful than BERT. Multisearch arrived in 2022, letting you refine an image search with text keywords.

The latest and biggest news about Google AI is Bard, a chatbot you can access at bard.google.com. However, Bard’s results might not be accurate, so you still need Google Search. To learn more about chatbots, check out our guide to large language models. This year, Google also brought generative AI to search with its new AI-powered Search experience (SGE). You might see a Generative AI panel at the top of search results featuring a text overview, images, and video.

Since Google’s AI advances live in the cloud, you can access this powerful technology with an Android phone, iPhone, computer, or a nice Chromebook. However, BERT is still in use and continues to serve an important role in Google Search.

Khám phá thêm từ Phụ Kiện Đỉnh

Đăng ký để nhận các bài đăng mới nhất được gửi đến email của bạn.