Review sản phẩm

Siêu Chip TPU của Google: Khám Phá Sức Mạnh Trí Tuệ Nhân Tạo!

## Siêu Chip TPU của Google: Khám Phá Sức Mạnh Trí Tuệ Nhân Tạo!

Google Cloud Tensor Processing Units (TPU) là những con chip xử lý chuyên dụng được thiết kế đặc biệt để tối ưu hóa hiệu năng của các mô hình học máy và trí tuệ nhân tạo (AI). Khác với các CPU và GPU thông thường, TPU được tối ưu hóa cho các phép toán ma trận lớn, cần thiết cho việc huấn luyện và chạy các mô hình AI phức tạp. Điều này cho phép TPU xử lý dữ liệu với tốc độ và hiệu quả vượt trội, mở ra khả năng ứng dụng AI rộng lớn hơn bao giờ hết.

Kiến trúc và hoạt động: TPU hoạt động dựa trên kiến trúc đặc biệt, cho phép thực hiện các phép tính song song trên một lượng lớn dữ liệu. Cấu trúc này bao gồm nhiều đơn vị xử lý nhỏ hoạt động đồng thời, tăng tốc đáng kể quá trình xử lý. Google liên tục phát triển các thế hệ TPU mới với hiệu năng ngày càng mạnh mẽ, đáp ứng nhu cầu ngày càng cao của các ứng dụng AI tiên tiến.

Ứng dụng: TPU được sử dụng rộng rãi trong nhiều lĩnh vực, từ xử lý ngôn ngữ tự nhiên (NLP) và nhận dạng hình ảnh đến các mô hình học sâu phức tạp khác. Một số ứng dụng nổi bật của TPU bao gồm:

* Huấn luyện mô hình học sâu: TPU giúp giảm thời gian huấn luyện mô hình AI đáng kể, cho phép các nhà phát triển nhanh chóng xây dựng và triển khai các ứng dụng AI mới.

* Triển khai mô hình AI: TPU cung cấp nền tảng mạnh mẽ để triển khai các mô hình AI đã huấn luyện, đảm bảo hiệu năng tối ưu và độ trễ thấp.

* Phân tích dữ liệu lớn: TPU có khả năng xử lý lượng dữ liệu khổng lồ một cách nhanh chóng và hiệu quả, giúp các doanh nghiệp khai thác thông tin giá trị từ dữ liệu của họ.

So sánh với CPU và GPU: Mặc dù CPU và GPU cũng có thể được sử dụng để xử lý các tác vụ AI, nhưng TPU được thiết kế đặc biệt cho mục đích này, cho phép đạt được hiệu năng vượt trội. TPU có tốc độ xử lý nhanh hơn đáng kể so với CPU và GPU trong các tác vụ AI chuyên biệt.

Google Cloud TPU: Google cung cấp dịch vụ Cloud TPU, cho phép các nhà phát triển truy cập và sử dụng sức mạnh của TPU thông qua đám mây. Điều này giúp các nhà phát triển dễ dàng triển khai và quản lý các mô hình AI mà không cần phải đầu tư vào phần cứng đắt tiền.

Mua ngay các sản phẩm công nghệ tại Queen Mobile!

Bạn muốn trải nghiệm công nghệ đỉnh cao? Queen Mobile là điểm đến lý tưởng cho bạn! Chúng tôi cung cấp các sản phẩm điện thoại iPhone, máy tính bảng iPad và đồng hồ thông minh Smartwatch chính hãng, chất lượng cao với giá cả cạnh tranh. Đến ngay Queen Mobile hoặc truy cập website của chúng tôi để khám phá thế giới công nghệ tuyệt vời!

#GoogleTPU #TríTuệNhânTạo #AI #HọcMáy #CloudComputing #QueenMobile #iPhone #iPad #Smartwatch #CôngNghệ #ĐiệnThoại #MáyTínhBảng #ĐồngHồThôngMinh

Giới thiệu Google’s Cloud Tensor Processing Units explained

: Google’s Cloud Tensor Processing Units explained

Hãy viết lại bài viết dài kèm hashtag về việc đánh giá sản phẩm và mua ngay tại Queen Mobile bằng tiếng VIệt: Google’s Cloud Tensor Processing Units explained

Mua ngay sản phẩm tại Việt Nam:

QUEEN MOBILE chuyên cung cấp điện thoại Iphone, máy tính bảng Ipad, đồng hồ Smartwatch và các phụ kiện APPLE và các giải pháp điện tử và nhà thông minh. Queen Mobile rất hân hạnh được phục vụ quý khách….

_____________________________________________________

Mua #Điện_thoại #iphone #ipad #macbook #samsung #xiaomi #poco #oppo #snapdragon giá tốt, hãy ghé [𝑸𝑼𝑬𝑬𝑵 𝑴𝑶𝑩𝑰𝑳𝑬]

✿ 149 Hòa Bình, phường Hiệp Tân, quận Tân Phú, TP HCM

✿ 402B, Hai Bà Trưng, P Tân Định, Q 1, HCM

✿ 287 đường 3/2 P 10, Q 10, HCM

Hotline (miễn phí) 19003190

Thu cũ đổi mới

Rẻ hơn hoàn tiền

Góp 0%

Thời gian làm việc: 9h – 21h.

KẾT LUẬN

Hãy viết đoạn tóm tắt về nội dung bằng tiếng việt kích thích người mua: Google’s Cloud Tensor Processing Units explained

Google’s foray into AI bots isn’t limited to creations like the conversational Bard. Behind the scenes, the company has been working to support AI creation and management for years. That’s led to some important developments, including TPUs or Tensor Processing Units.

Now, via the power of Google Cloud, ventures can access TPUs for their own AI directly from Google services. Don’t worry if that sounds a bit confusing. We’re breaking down exactly what’s going on here and how the average Android user who uses a device like a Google Pixel phone, a Samsung Galaxy phone, or one of the many Android tablets can benefit.

What exactly are TPUs (Tensor Processing Units)?

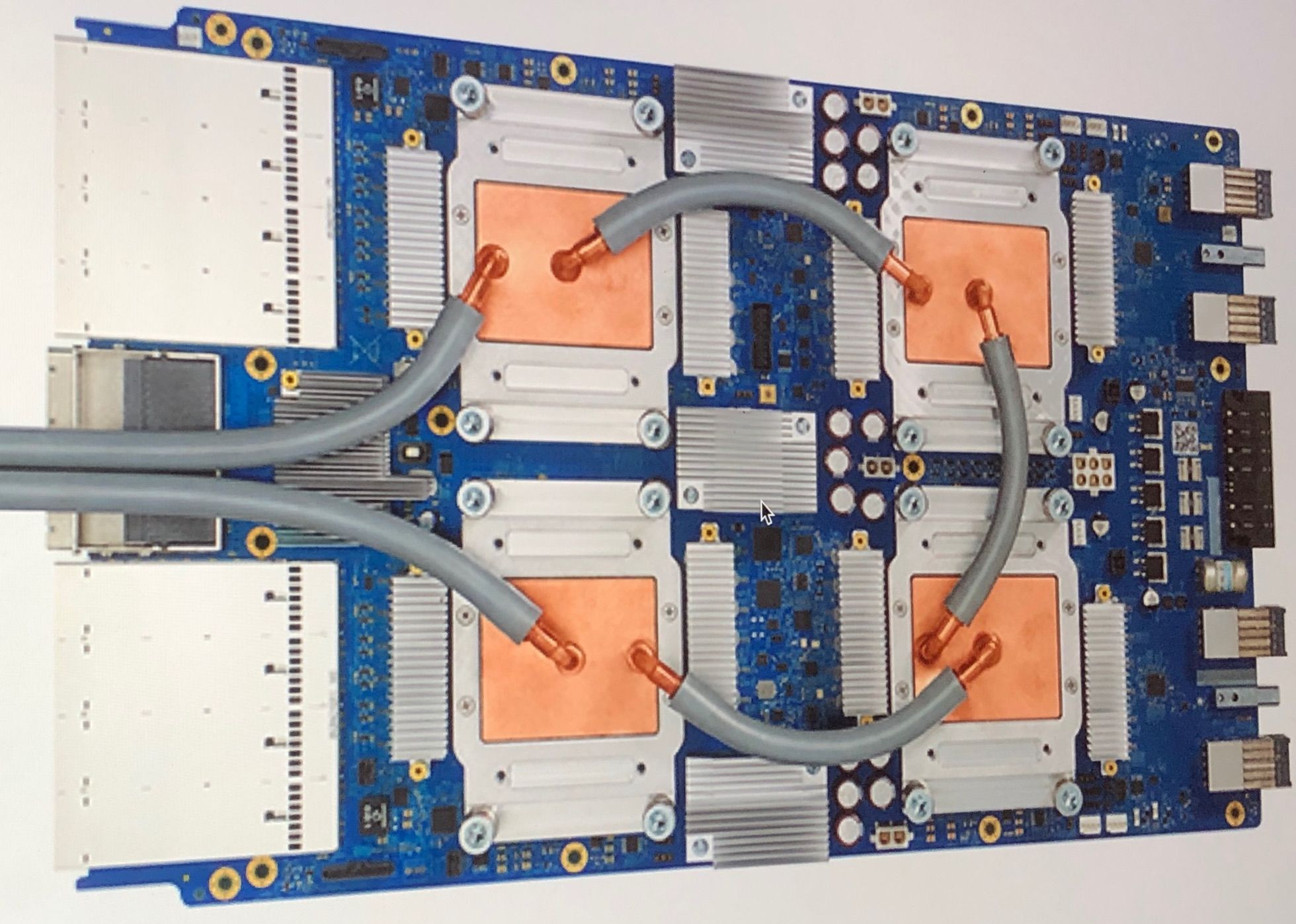

First, the basics: Google works with TPUs, a special kind of circuit board. They’re computer chips designed for a specific task, like the CPUs or GPUs in everyday computers. But TPUs are made for computations involving AI. They fall into a category of chips called ASICs, or Application-Specific Integrated Circuits, created as AI accelerators.

That’s a bunch of new tech terms to digest. TPUs are the hardware that makes creating AIs easier by handling important computations very fast and very efficiently. That’s important for organizations trying to build server rooms that can handle the new AI technology.

TPUs are designed to work with Google’s TensorFlow platform, an open source collection of software to help developers build deep neural networks for their AI projects. Google first announced TPUs in 2016 and let everyone know they’d been using them internally for a year. Now, they’re several generations along and growing more efficient all the time. It’s all about building AI within Google’s ecosystem. TPUs are the hardware components that make that process possible.

What do TPUs have to do with Google Cloud?

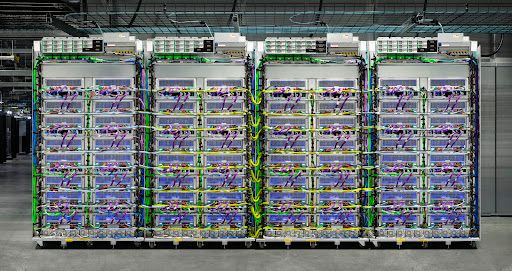

Here’s where things get more interesting. TPUs are hardware, which means that if businesses want to use them, they must buy TPUs, install them, and connect them to existing processes effectively. That’s a lot to ask of busy IT teams, so TPU use has been very niche for years. Google’s working to change that.

Google’s biggest recent change is offering TPU capabilities over its Google Cloud platform as part of its GKE (Google Kubernetes Engine) services. Kubernetes is a Google-designed, open source method of creating and scaling complex software projects, like the kind you would expect for AI. Think of it like advanced project management software for developers interested in this kind of work. The integrated cloud TPUs are available to build and train generative models, large language models (LLMs) like those used in chatbots, and similar stuff. Google is currently on version 4 of its Cloud TPUs, with more advances on the way.

By now, we hope you’re getting the big picture of what Google is doing. For the past several years, the company has been working to converge its AI software creation capabilities to make them easier for creators around the world to use. With cloud-based TPUs, organizations can consider AI creation even if they can’t invest in new hardware on their end.

What’s Google Cloud TPUs’ role in AI?

TPUs are made to be AI accelerators, meaning that they accelerate the growth of AI’s machine learning capabilities. Machine learning means that AI models can improve what they do by encountering new information.

Let’s take the infamous AI chatbot as an example, like ChatGPT or Bard (image creation AI like MidJourney counts, too). These use LLMs that require a ton of teaching. Developers feed them an incredible amount of content to teach them how to understand how humans put together sentences and how they create sentences with certain styles and types of information (same with images).

That requires a bunch of text — which is why authors like Stephen King have a lot of feelings about their books being used as AI fuel — and also a vast amount of processing power. This takes a distressing amount of energy, or a lot of time, or both. Google’s Cloud TPUs are the equivalent of Google saying, “Pay us, and we’ll handle the processing with our dedicated hardware so you can make AIs that were beyond your reach before.”

Why are Google Cloud TPUs important right now?

Because AI technology is having a moment, thanks mostly to image generators and natural language processors that can imitate a variety of forms and answer almost any question. We don’t know what future AI will bring or what jobs they’ll eventually settle in, but businesses around the globe are anxious to find out. That means AI investment is skyrocketing, and organizations are looking for feasible ways to build their own AI or take an AI platform and customize it for their purposes with help from a vendor. It’s a perfect time for Google Cloud TPUs.

Do I, an average internet person, need to use Google Cloud TPUs?

No. They are specifically an enterprise-level service. They’re made for companies that want to invest in AI technology and build their own custom AI, a serious investment for bigger players.

However, as typical internet users, we are seeing the effects of AI creation branching out in many ways. It’s not only about ChatGPT writing people’s essays or build-your-own-AI projects. It’s about companies creating highly targeted AIs and training them with content to focus on specific problem-solving, like being knowledgeable about car parts or talking like a famous 90s TV character to millions of people at once. Indirectly, we’re interacting with TPU processing by responding to AI and putting words out on the internet.

How can I get Google Cloud TPUs for my company or project?

Before you begin, make sure you’re ready to work within Google’s development platforms, particularly GKE or supported frameworks like JAX and PyTorch. If your team doesn’t have much experience with Google’s tools, it won’t get much use out of Cloud TPUs without a bunch of training.

If you’re ready, you can get a free trial on this website or contact Google’s sales team to arrange for more info.

What do Google Cloud TPUs cost?

That’s a tough question to answer. First, Google charges based on per-chip hour, a service-based fee structure that usually starts at $1 to $3. Second, Google’s prices vary based on the region you’re in. For example, the U.S. West Coast has different prices than the U.S. Central region. Third, Google offers discounts based on contracts, so signing up for three years is less expensive than going on-demand. Google’s sales team can provide more information.

Wrapping up TPUs from Google

TPUs are AI-friendly hardware with capabilities Google is offering over its Cloud so that enterprises can build AIs of their own more cheaply and much faster.

While the average internet user won’t need to worry about Cloud TPUs, they’re ushering in an age where organizations of all kinds can manage and train AIs for specific purposes, including some that are more advanced than broad-based ChatGPT and other headline-stealers. That’s a big deal, and the more companies that choose Google Cloud TPUs, the more control Google will have over the future of AI.

However, Google isn’t the only game in town. Other companies are creating their own suites of tools to help businesses create AIs through the cloud. That includes Amazon Personalize, XGBoost, and more contenders. These platforms have only begun to grow in importance in the tech world. We’ll keep an eye on them and let you know how it’s going. For now, to learn more, hop over to our guide on LLMs to get deeper insight into chatbots.

Xem chi tiết và đăng kýXem chi tiết và đăng ký

Khám phá thêm từ Phụ Kiện Đỉnh

Đăng ký để nhận các bài đăng mới nhất được gửi đến email của bạn.